Mitä tuosta postauksestasi ihmisten on tarkoitus saada irti?

Not ok, google. Voice assistant -tiimi nähtävästi sai fudut: Google Among Tech Companies Laying Off Nearly 1,700 Workers.

Bardi korvannee.

Se osaa sana kerrallaan tuottaa seuraavan sanan mikä todennäköisimmin passaa jo kirjoitettuun tekstiin ja esitettyyn kysymykseen, training datan perusteella. No more, no less.

Sitä aika usein itsekin mietin.

Uskoisin ymmärtäväni ainakin jotain transformereista ja muistakin tekoälyalgoritmeista, kun työkseni joudun/pääsen näiden kanssa tekemisiin ja akatemiankin puolella tulee vaikutettua. Silti jaksan yhä hämmästyä uudelleen ja uudelleen tekoälyn viimeaikaisista edistysaskeleista ja nykyisistä kyvykkyyksistä (esim. näiden multimodaalisten kielimallien osalta).

Itseäni ei juuri kiinnosta filosofinen pohdinta siitä, mikä on tekoälymallien älyn luonne tai vastaavuustaso suhteessa ihmisen tai muiden lajien kognitiokykyihin. Olen ehkä enemmän insinööri kuin humanisti ja kiinnostuksena on lähinnä se, onko tekoälystä jotain hyötyä. Mielestäni vastaus tähän on yksiselitteisesti kyllä ja hyöty kasvaa tällä hetkellä eksponentiaalisesti uusien innovaatioiden syntyessä aivan häkellyttävällä vauhdilla.

Mielestäni on myös jokseenkin hölmöä refutoida esim. LLM-mallien vallankumouksellisuus siksi, ettei ne suoriudu joistain ihmisille helpoista tehtävistä. Samaan aikaan ne päihittävät yli-inhimillisesti ihmisten kyvyt mm. muistin ja prosessoinnin osalta. Jopa pieniparametrinen LLM esim. puhuu varmasti paremmin useampaa kieltä samanaikaisesti kuin kukaan muu tällä planeetalla.

Heittäydytään nyt kuitenkin hieman humanistiksi. En nyt viittaa @faravid suoraan sinuun, mutta välillä tekoälyn merkitystä ja kyvykkyyksiä vähättelevistä puheenvuoroista paistaa sellainen ihmisluonnolle ominainen ylivertaisuusajattelu. Meille on tyypillistä ajatella, että jokin asia on hyvä vain, jos se toimii täydellisesti siinä rajallisessa kykyavaruudessa, jossa itse toimimme. Uskon, että esim. itseajavissa autoissa tämä tulee olemaan suurin este niiden käyttöönotolle. Jos itseajava auto tekee pienenkin virheen, jonka koetaan olevan sellainen, ettei ihminen sitä olisi tehnyt, niiden varmuuteen ei luoteta.

Eikä yllä oleva tarkoita, etteikö AI:n safetya ja securitya tulisi parantaa. Tässäkin on taas hyvä vetää analogia internetin kehitykseen Netscapen ajoilta. Eiköhän ole aika selvää, että nuokin osa-alueet tulevat paranemaan ihan vastaavasti kuin internetinkin osalta on tapahtunut ja tapahtuu jatkuvasti.

Tavallaan kirjailja Roald Dahl esitti ChatGPT’n idean vuonna 1954 novellissaan The Great Automatic Grammatizer. Bingin GPT’n referaatti novellista:

Novellin päähenkilö on mekaanisesti lahjakas mies, joka keksii tavan kirjoittaa kirjoja automaattisesti käyttäen hyväkseen kieliopin sääntöjä. Hän rakentaa koneen, joka kykenee kirjoittamaan palkitun romaanin noin viidessätoista minuutissa. Tarina päättyy pelottavasti, kun yhä useammat kirjailijat joutuvat lisensioimaan nimensä ja kaiken toivon ihmisen luovuudesta koneelle

No insinööri minäkin olen.

Nämä nykyiset kielimallit ovat lähinnä tuoneet näkyväksi sen, kuinka helposti me ihmiset erehdymme luulemaan, että sopivasti järkevän kuuloista (pinnallista) shaibaa suoltava lähde - oli se sitten ihminen tai kone - olisi jotenkin erinomaisen älykäs ja pätevä alalla, josta hän kantaa ottaa.

Jotkut meistä pidempään eläneistä ihmisyksilöistä onkin jo ihan omalla päätellyllään kyenneet havaitsemaan ilmiön, että shaiba uppoaa ihmisiin aivan liian hyvin ja helposti. Sitä ei voi käyttää osaamisen mittarina.

Miten tästä eteenpäin? Sellainenkin kehityspolku on mahdollinen, että turha shaibansuolto alkaa kyllästyttämään ihmisiä koska ChatGPT:n tapaiset koneet tekevät siitä jakkukalkkunoiden suoltamasta corporate-bullshitistä niin yleistä, että joka paikka hukkuu siihen paskaan. Vastareaktiona ihmiset kyllästyvät siihen ja alkaat vaatia tilalle aitoa älyllisyyttä. Aitoa älyä. Aitoja oivalluksia eikä konesuollettua paskaa.

Tulee mieleen keväällä käydystä ChatGPT kurssista se eturivin merkonoomi-tradenoomi jakkukalkkunoiden innostus ChatGPT:n tapaisesta puppugenusta: Jihaa! Nyt on työkalu jolla voi täyttää ne corporaation some-kanavat ja bloigut täyteen ChatGPT:llä suollettua bullshittiä, joka näyttää niin menevältä meiningiltä että. Että meidänkin firma seuraa niin aikaansa…Eikä työhommiin mene kun 1h tunti aikaisemman 4h sijaan. (Nyt voikin sitten käyttää säästyneet 3h kahvilla istumiseen ja tyhjänpäiväiseen pulputtamiseen vaikka vauva.fi palstalla)

Eikä kyseiset ihmiset vaikuttaneet olleskaan huolestuneelta siitä, ettei tuollaisessa generoidussa skeidassa ole oikeasti mitään aitoa sisältöä - ja kun ihmiset huomaavat mistä on kyse niin juoksevat lujaa karkuun. Ilmeisesti heidät oli palkattu eri puolille Suomen yrityselämää täyttämään firmojen viestintäkanavat shaiballa? Sellainen ikävä jälkimaku ainakin minulle asiasta jäi. Kurssilla oli siis laajasti eripuolilta Suomea tulleita ihmisiä, joten saattoi tämmöisiä sivuhuomioita marginaaliin tehdä.

Luulen, että sulla on nyt hieman väärä tilannekuva LLM:ien kyvyistä. Esim. LLM:ien tuottama ohjelmistokoodi ei ole mitään “sopivasti järkevän kuuloista (pinnallista) shaibaa” vaan tutkimusten mukaan esim. 50% Githubin Copilotinmallin tuottamasta outputista menee sellaisenaan code reviewstä läpi. Tuottavuus- ja tyytyväisyysparannukset mitataan siellä 60-90% välimaastossa.

Teet mielestäni yhden tapahtumahavaintojen perusteella aika pitkälle meneviä johtopäätöksiä. Tuosta voi lukea ihan aitoa tutkimusta siitä, miten “jakkukalkkunat” maailman kolmen arvokkaimman konsulttiyhtiön joukkoon kuuluvassa BCG:ssä paransivat tuottavuuttaan ja laatuaan GPT:n avulla. Sieltä selviää myös, millaisiin työtehtäviin GPT tuo lisäarvoa ja millaisiin ei: https://www.hbs.edu/ris/Publication%20Files/24-013_d9b45b68-9e74-42d6-a1c6-c72fb70c7282.pdf

ChatGPTn suoltamaa tekstiä voi käyttää moneen hyödylliseen asiaan, mutta niin kuin moni muukin työkalu, sitä pitää osata käyttää oikein. Jos sitä yrittää käyttää taikalaatikkona josta parilla virkkeellä saa pitkän tekstin jonka voi suoraan copypasteta jonnekkin jakoon ja sitten karata tekemään jotain kivaa, ura AI:n hyödyntäjänä voi jäädä lyhyeksi kun tulee pistäneeksi jakoon sitä puppua.

Suurin ongelma on että valtaosa ihmisistä ei ymmärrä ChatGPTn toimintaperiaatetta ja kun se sattuu heittämään sellaisenaan hyvää tavaraa pari kertaa puolivahingossa, laiska mukavuudenhaluinen ihminen luonnollisesti näkee tilaisuuden mennä sieltä mistä aita on matalin. Ja mikä pahinta, tämä voi toimia jonkin aikaa kunnes sitten ei toiminutkaan.

ChatGPT ei poista tarvetta asiantuntijoille vaan pikemminkin niitä tarvitaan entistä kipeämmin, koska se todellinen asiantuntija osaa nopeasti tuunata kielimallin ulostaman tekstin kuntoon. Vähemmän osaava helposti valahtaa nyökyttelemään että kaipa tuo on oikein. Sen sijaan se voi nostaa asiantuntijoiden tuottavuutta ja toimia muistin tukena. Se joka ei tätä ymmärrä on (tuhoon) tuomittu ajamaan kiville bottitekstin kyydissä, todennäköisesti ennemmin kuin myöhemmin.

Joka ainoa kerta kun luen artikkeleita kuinka firma X on alkanut käyttämään bottailtua tavaraa sisältöönsä kaksin käsin, pistän muistiin että tuon firman johto on täynnä idiootteja. Kyllä, hekin ennen pitkää oppivat mutta kantapään kautta oppiminen on kallista.

Itsellä tausta koodaajana, joskin jo vuosia yritysarkkitehtina. Tosin olen aina koodaillut useilla niistä kielistä, joita yritysarkkitehtuurissa käytetään. Hieman koodaillut neuroverkkoja, mutta en siinä mikään spesialisti.

Mielestäni keskeinen pohdinta tekoälyn ja generatiivisen tekoälyn (jolla viitattanee nykyisin Transformerin käyttöön) vertaus ihmisen älykkyyteen on siinä, että kuinka paljon voidaan luottaa tekoälyn matemaattiseen todennäköisyyslaskentaan verrattuna ihmisen älyyn, jossa ihmisaivot voivat käyttää luovasti ongelmanratkaisuissa kaikkea oppimaansa ja muistamaansa.

Tämän vuoksi autonomiset autot eivät ole toimineet vielä luotettavasti. Kun ihminen ajaa vaikka risteyksessä ja kohtaa ennen kokemattoman tilanteen, ihmisen aivot kykenevät pohtimaan luovasti ratkaisun.

Jos tekoälylle tätä tilannetta ei ole opetettu, ei se kykene reagoimaan.

Ihminen oppii asioita ja muistaa ne. AI:ssa parametreja opetusvaiheessa ajetaan kohti optimiarvoja ja tuotannossa näillä saa keskimäärisesti parhaan tuloksen. Mitä enemmän parametreja ja dataa, sitä parampi erottelukyky.

Tesla on lähtenyt uusimaan FSD:n koko arkkitehtuuria ChatGPT:n kaltaiseen ratkaisuun. Koko arkkitehtuuri pohjautuu Transformereihin ja toiminta End2End-ratkaisuun. Tässä AI:lle ei opeteta eri prosesseissa eri objekteja, ennusteta niiden liikkeitä ja suunnitella ajoreittiä. AI:lle näytetään kameran koko kuva, josta se oppii itse päättelemään, että kun on tuon kaltaiset muodot (esim. Stop-merkissä), niin toimi näin jne.

Idea on sama kuin ChatGPT/GPT:ssä, valtava määrä parametreja ja valtava määrä dataa, niin kyky/erottelykyky eri tilanteisiin reagointiin paranee.

Optimitilanteessa saisimme “todennäköisyyslaitteen”, joka kykenee 99.9999% tarkkuudella reagoimaan oikein, mutta ei tajua ihmisen kaltaisesti mitä tekee. Kameran kuva vain menee valtavan määrän parametreja läpi laskutoimituksineen

Se on juuri näin. Tuossa linkkaamassanni tutkimuksessa todetaan sama jo heti ensi sivuilla: “The advantages of AI, while substantial, are similarly unclear to users. It performs well at some jobs, and fails in other circumstances in ways that are difficult to predict in advance”.

Kuitenkin se, että ihmiset eivät ymmärrä, miten tai mihin GPT:tä tulisi käyttää, ei tee itse teknologiasta huonoa - kuten ehkä edellä annettiin ymmärtää.

Se että nykyiset tekoälyt tuomitaan “puppugeneraattoreina” on kyllä huvittavaa. Ehkä olisi syytä huomioida miten alkutaipaleella tämän teknologian kanssa ollaan sekä kehitysvauhti millä eteenpäin mennään. Maailma tulee olemaan todella erilainen paikka 5-10 vuoden sisään.

Näin se on. Toisaalta tässäkin on tavallaan ristiriidassa ihmisen “kaikkivoipaisuus” ja tekoälyn kyky optimoida jotakin objektiivifunktiota. Olen täysin vakuuttunut, että isossa mittakaavassa tekoäly kykenee jo lähitulevaisuudessa ylittämään täysin ylivoimaisesti ihmisen ajokyvyt, kun mittarina on esim. liikenneonnettomuudet tai niiden aiheuttamat kustannukset.

Mun tutkimuksiin perustuva väite on, että ihmismieli arvottaa tekoälyn töpeksinnän monin verroin ankarammin kuin ihmisen virheet. Väitän, että autonomisen auton tulee olla lähes täysin virheetön ennen kuin annamme sille vastuun. Jos autonominen auto töpeksii esim. pikkulapsen kuoliaaksi, ei auta vaikka liikenneturvallisuus olisi kokonaisuudessaan parantunut sadoilla prosenteilla tai että Jorma 1.5 ‰ humalassa ajoi myös viikkoa ennen pikkulapsen yli.

Tämä on ihan oikea tuomio, koska nykyinen tekoäly ei omaa oikeasti mitään älyä, eli se ei “tiedä” mitään tekstistä. Kielimallit tulevat aina ja ikuisesti suoltamaan jollain prosentilla tavaraa joka on asiaa osaavalle ihmiselle täysin yksiselitteisesti heti tuomittavissa pupputekstiksi.

Kyllä, tekstin laatu paranee teknologian parantuessa, mutta fundamentaalisesti käytetty tapa on sellainen että 100% on tavoittamattomissa. Ja tuo yllä mainittu pointti että koneiden virheitä ei suostuta katsomaan läpi sormien samalla tavalla kuin ihmisten virheitä tarkoittaa sitä että AI-tekstibotti joka on oikeassa 99% ajasta saa silti päähänsä leiman “puppugeneraattori” kun se kerran sadasta menee lirauttamaan ulos virheen.

Lisäksi on ongelmallista että kun laatu paranee ja virheet vähenevät, luotto nousee ja eeppisten epäonnistumisten todennäköisyys jopa kasvaa. Jos kielimalli mokaa päivittäin, käyttäjä varmasti katsoo perään. Jos kielimalli mokaa kerran kuukaudessa, on iso riski että kukaan ihminen ei katso perään ennen kuin teksti on jossain paikassa jossa se aiheuttaa isomman katastrofin.

Tämä voi olla näin mutta se kertoo lähinnä ihmisen typeryydestä.

Mitä tarkoitat kun sanot “ei kykene reagoimaan”? Auto lamaantuu? Vai tekee mielestään turvallisimman ratkaisun? Ei ajamisessa ole yleisesti ottaen yhtä oikeaa ratkaisua vaan paikasta A paikkaan B voi liikkua monella eri tavalla joissa mm. vauhti, riskinotto ja liikenteen yleinen sujuvuus voi vaihdella. Ei kaikki ihmisetkään aja yhtä hyvin keskenään mutta silti pääsääntöisesti liikenne sujuu ja selvitään kotiin elossa.

Periaatteessa tekoäly laskee valtavasta datamassasta todennnäköisyydet huikeasti ihmistä paremmin. Tämä on riittävä todelle moneen käyttötapaukseen.

Tekoäly ei kuitenkaan mielestäni korvaa ihmisen älykkyyttä, ennen kuin nykyinen tapa oppia (backpropagationissa optimikohtia säädettävät parametrit) muuttuu.

@faravid kysyi miten GPT/Transformer toimii

Omasta mielestäni keskeistä on ymmärtää vektoritietokannat, jotka tulevat yleistymään Transformerin ja GPT:n myötä.

Omasta mielestäni opetusvaiheessa Transformer etsii halutulle datajoukolle (esim. sanaston sanoille) optimaaliset vektorien arvot niiden välisten suhteiden mukaan. Tuotannossa GPT tietää mitä sanoja on siihen mennessä annettu ja se antaa todennäköisyyden seuraavaksi sanaksi perustuen annettujen sanojen välisiin suhteisiin.

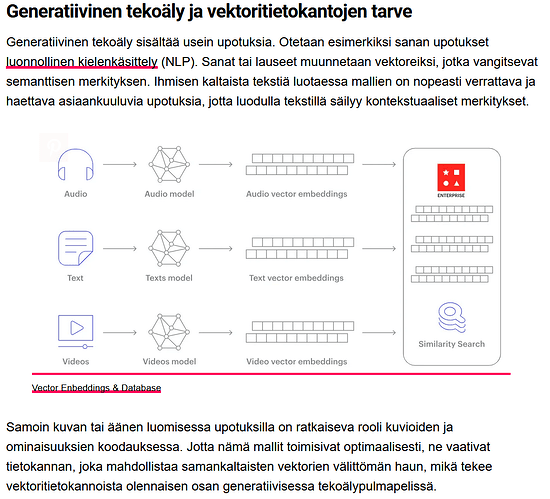

Edit Tässä kuva eri datan viennistä vektoritietokantaan. Myös Transformer kykenee käsittelemään erilaista dataa.

Luulen, että keksit ihan Olkinuken minun sanomakseni ja lähdit nuijimaan sitä alas.

En ottanut mitään kantaa LLM generoimaan koodiin. Siellä se on varmasti hyödyllinen työkalu, “älykkäänä template” työkaluna.

Toimii tosin vain sellaisella koodilla ja ohjelmointikielellä, josta on runsaasti laadukasta matskua internetissä (esim. Stackoverflow)

Sen sijaan joku harvinaisempi koodi, esim. sulautettujen ohjemointi tai vaikkapa COBOL. Turha luulla että ChatGPT paljon jeesii.

Ja niissäkin tilanteissa, missä ChatGPT:lstä on AMMATTILAISELLE tuottavuushyötyä, vastuu toimivuudesta on sillä ammattilaisella. Kuten @anon86311303 tuossa yllä ansiokkaasti yhtä keissiä kuvasikin. Amatööri ei saanut mitään toimivaa aikaiseksi, koska oma ymmärrys puuttui. Koodipuppugenu nimeltä ChatGPT ei ollutkaan hyödyllinen suoltaja, koska vain 50% oikein on kamalan paljon väärin!

Lopuksi,minähän kerroin vain mitä kurssillani näkemä kaakattava jakkukalkkunaseurakunta hillui innosta hihkuen ChatGPT:n ympärillä. Ilmiselvästi olematta ymmärtämättä mistä on oikeasti kyse. Taatusti se jälki näkyy myöhemmin korporaatioiden “viestinnässä”.

Ei pidä yleistää kommenttiani tuon kontekstin ulkopuolelle kaikkiin asioihin päteväksi.

Hyvänä esimerkkinä eräs tuttuni loi chatGPT itselleen hienon näköiset kotisivut ja sen jälkeen tappeli päiväkausia muutamien visuaalisten ongelmien kanssa, koska ei ymmärrä HTML5 ja CSS tarpeeksi hyvin voidakseen korjata ne manuaalisesti eikä osaa tekoälyllekään selostaa asiaa niin, että korjaus onnistuu.

Koodin lukemiseen menee sen elinkaaren aikana yleensä paljon enemmän aikaa kuin sen kirjoittamiseen. Kuten esimerkkisi osoittaa, ohjelmistoarkkitehtuurin suunnittelu ja koodin kirjoittaminen on myös hyvää harjoitusta tekoälyn generoiman koodin ymmärtämiseen. Puhumattakaan siitä että osaa antaa tekoälylle halutun koodin tuottamiseen tarvittavat syötteet.

Asiaa ei paranna se, että “älykkyys” on jo kauan aikaa sitten kokenut inflaation ja sillä on alettu tarkoittaa mitä tahansa joka ei ole pelkkää mekaniikkaa tai elektroniikkaa. Ihmisille, joilla ei ole mitään mahdollisuuksia ymmärtää mitä ne “älykkäät” härvelit oikeasti peltien alla tekevät, olettavat että nimitys kertoo jotain siitä härvelin sielunelämästä. Ja kun GPT:tä nyt on suunnilleen vuoden päivät hypetetty joka paikassa, niin ei sinänsä ole mikään ihme että tekniikasta mitään ymmärtämättömät ihmiset kuvittelevat että kyse olisi jostain todella ihmeellisestä (ja siinä auttaa suuresti chat-rajapinnan kyky vastata näennäisen älykkäästi). Esititkö sinä siellä AI-kurssilla kriittisiä kysymyksiä, vai tyydyitkö jurottamaan takarivissä ja naureskelemaan partaasi? ![]()

Jos tässä haluis olla oikein todella karhu (vai realisti?), voisi ennustaa että kyllä tulee vielä kolmaskin AI-talvi ennenpitkää, koska tää hype on sellaisella tasolla ettei kaikkia lupauksia todellakaan pystytä lunastamaan, ja siinä kohtaa poskettomien summien kaataminen alalle (jälleen) hiipuu. Ei se tapahtuessaan suonkaan tarkoittaisi ettei transformereista olisi mihinkään, on se jo kuitenkin nähty että niille voidaan löytää hyödyllistäkin käyttöä. Ja olihan neuroverkoistakin lopulta siis hyötyä, vaikka ekan AI-hypen jälkeen 60-luvun lopulla ne oltiinkin hautaamassa lopullisesti toimimattomana konseptina. Siinä vain meni reilu puoli vuosisataa ![]() ja välillä kokeiltiin kaataa rahaa toisenlaiseen ratkaisuun (“expert systems”) jossa myös taidettiin mennä hypen puolelle, kunnes huomattiin ettei sekään pystynyt lunastamaan lupauksia.

ja välillä kokeiltiin kaataa rahaa toisenlaiseen ratkaisuun (“expert systems”) jossa myös taidettiin mennä hypen puolelle, kunnes huomattiin ettei sekään pystynyt lunastamaan lupauksia.

Oma ensikosketukseni neuroverkkoihin oli yliopistossa tuon toisen “talven” aikana ennen “syväoppimisen” keksimistä, joten nojaan tässä historian osalta tuohon Wikipedia-artikkeliin. Tosin kyllähän niihinkin aikoihin esim. metsäteollisuudelle taidettiin jo tehdä konenäön avulla juttuja, joita kai voisi myös kutsua “tekoälyksi” siinä missä “älykkään” leivänpaahtimenkin sisältämää algoritmia.

Anteeksi nyt, mutta tuo kuvankaappauksessasi näkyvä teksti on kyllä todella surkea konekäännös, mikä on tän keskustelun yhteydessä ihanan huvittavaa ![]()

Itselle tuossa käännöksessä uusi sana oli “upotukset”, enkä tiedä onko se virallinen käännös embeddings-sanalle. Muuten tekstistä tuli mielestäni tarvittava tieto esille niille, joille vektorikanta ei ole tuttu.

Mutta en ole sinun kaltainen syväosaaja (deep expert)