Poimin Q1 sijoittajapuhelusta joitakin Jensenin nostoja ja laitoin perään oman tulkintani siitä:

Jensen : Companies and countries are partnering with NVIDIA to shift the trillion-dollar installed base of traditional data centers to accelerated computing and build a new type of data center, AI factories, to produce a new commodity, artificial intelligence.

Elikkä tänään vielä 90% datacentereistä on ns. perusmallisia, ilman AI kiihdyttimiä. Sen takia infrauudistukset ovat tosiasiassa vasta alkamassa.

Jensen : Strong and accelerated demand – accelerating demand for generative AI training and inference on Hopper platform propels our Data Center growth. Training continues to scale as models learn to be multimodal, understanding text, speech, images, video and 3D and learn to reason and plan.

Multimodaalisuus takaa sen, että kysyntä ei vähene, vaan Jensenin mukaan kiihtyy. Tietysti prosentuaaliset kasvut tasoittuvat.

Jensen : Our inference workloads are growing incredibly. With generative AI, inference, which is now about fast token generation at massive scale, has become incredibly complex.

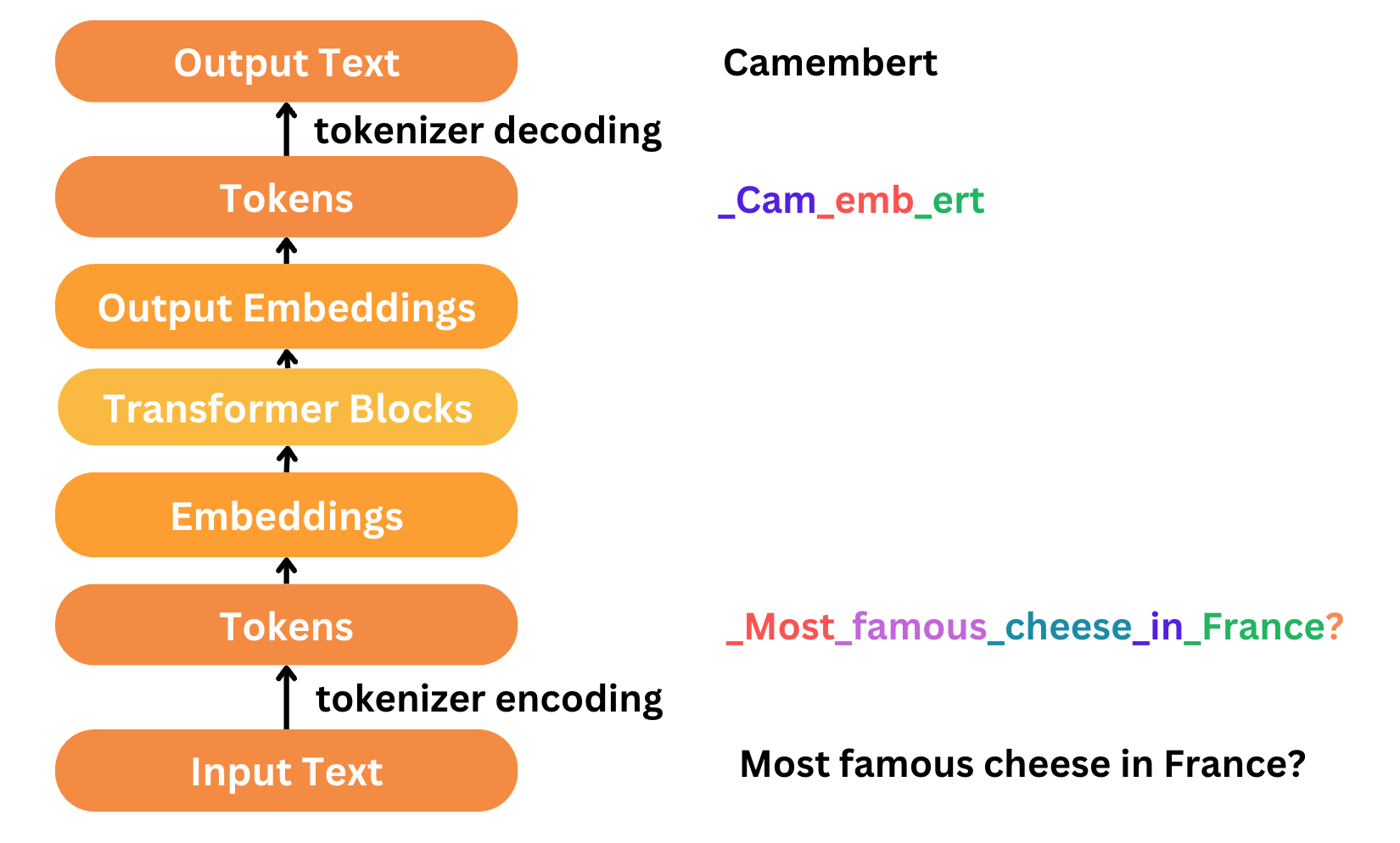

AI päättelyä viedään tokeneihin. AI-tokenien maailma on äärimmäisen monimutkaista. NVIDIA luo AI päättelymekanismeja ja ehkä AI päättelyä tekevät tokenit voivat kehittyä vaihdannan välineiksi?? NVIDIA näyttää jälleen arkkitehtuurista ja teknologista suuntaa ja muut tulee perässä.

Jensen : from producing software to generating tokens, manufacturing digital intelligence.

Tokenit ovat näitä pieniä tai miksei isojakin älysoluja. Niitä ei enää koodata, vaan nyt en oikein tiedä mitä sanoisin, sanotaan nyt niin, että niitä kasvatetaan, tai niille annetaan olosuhteet kasvaa ja kehittyä

Jensen : Token generation will drive a multiyear build-out of AI factories.

Koko AI toimiala jatkaa paisumistaan. NVIDIA auraa latua ja vetää laite ja infravalmistajat ja myös softataloja imuunsa.

Jensen : From today’s information retrieval model, we are shifting to an answers and skills generation model of computing. AI will understand context and our intentions, be knowledgeable, reason, plan and perform tasks.

Eli voidaan tehdä työtä tekemällä oppivia robotteja, ja vaikkapa Amazon voi korvata varastotyöntekijät roboteilla.

Jensen : The combination of Grace CPU, Blackwell GPUs, NVLink, Quantum, Spectrum, mix and switches, high-speed interconnects and a rich ecosystem of software and partners let us expand and offer a richer and more complete solution for AI factories than previous generations.

NVIDIA johtaa orkesteria, jossa kilpailijat saavat soittaa sooloja. NVIDIA hivuttaa kvanttilaskennan pikkuhiljaa osaksi Accelerated Computing ratkaisukokonaisuutta.